Proroci iz Silicijumske Doline malo mijenjaju ton. Barem neki od njih. Ne tako davno, tehnološki vizionari zamišljali su ružičastu budućnost punu dokolice i obilja. Ray Kurzweil, kompjuterski naučnik koga je angažovao Googleov suosnivač Larry Page da unaprijedi tehnologiju mašinskog učenja kompanije, jednom je predvidio oslobađanje iz zatvora smrtnog ljudskog tijela dok se svijest uzdiže u oblak. Danas najuticajniji futuristi iz Doline više ne prodaju toliko optimizma - uostalom, ko bi im uopšte vjerovao?

Čak i u ovoj ranoj fazi, tehnologije vještačke inteligencije prijete karijerama i stvaraju masovnu anksioznost među radnicima od kojih se očekuje da desetostruko povećaju svoj učinak uz pomoć ogromnog broja novih alata čija je vrijednost neizvjesna. Korporacije koje profitiraju od ovih tehnologija zaradile su bogatstvo piratovanjem dela autora i muzičara, dok se hvale poremećajima koje će izazvati u ekonomiji. Ovaj put ne vodi u utopiju.

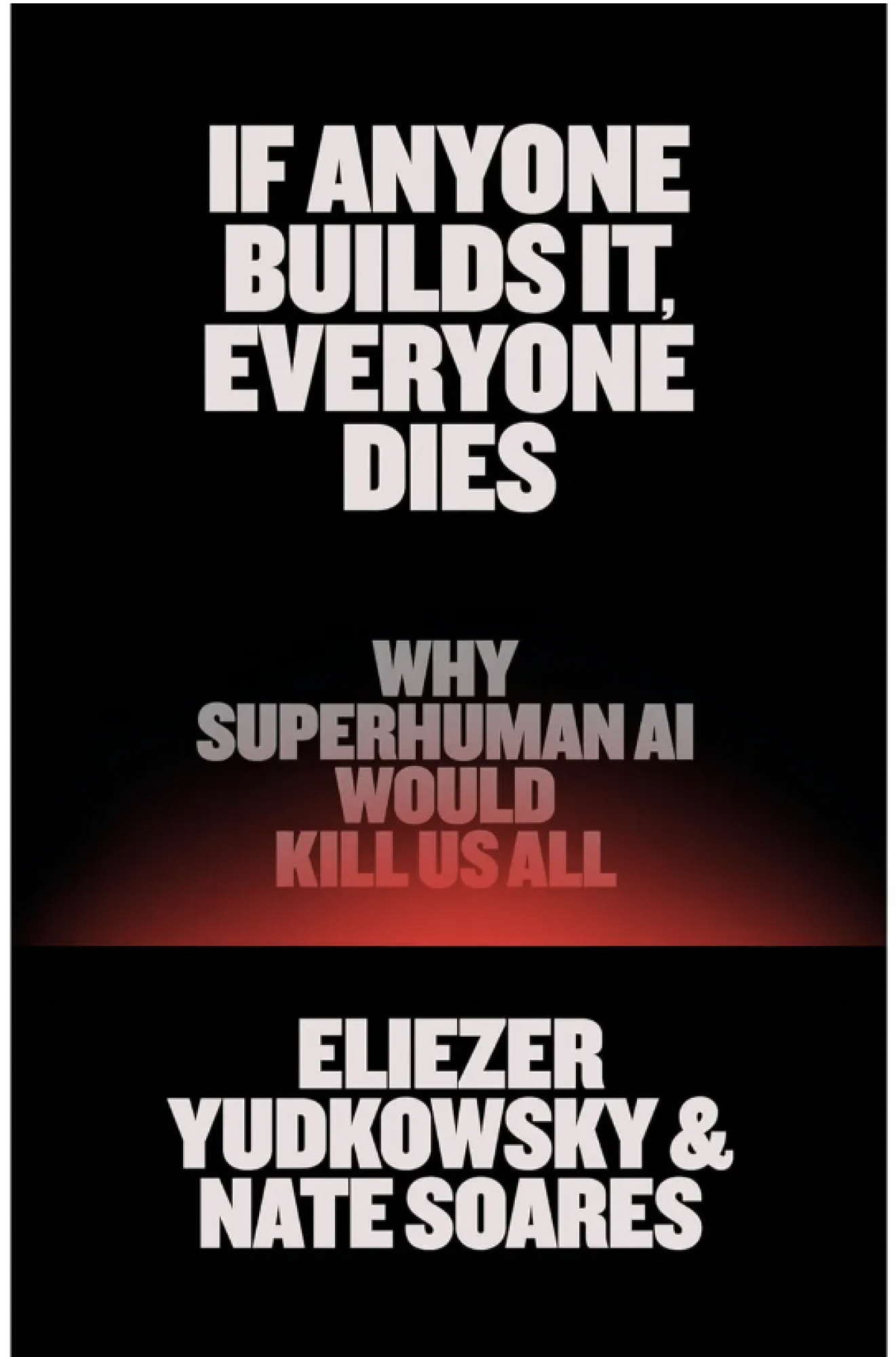

U svojoj novoj knjizi If Anyone Builds It, Everyone Dies (Little, Brown & Co., septembar 2025), istraživači vještačke inteligencije Eliezer Yudkowsky i Nate Soares takođe vide budućnost u kojoj tehnologija odvaja ljude od njihovih smrtnih tijela. Ali u ovoj budućnosti nema uspona u digitalni zagrobni život u oblaku, postoji samo smrt.

Naslovnica knjige koja će promijeniti sve što mislimo o AI | Bloomberg Adria

Naslovnica knjige koja će promijeniti sve što mislimo o AI | Bloomberg Adria

Autori se ne bave vještačkom inteligencijom kakva danas postoji: smrtonosno "to" iz naslova knjige nije AI u kolokvijalnom, nepreciznom smislu te riječi, koji "inteligenciju" pripisuje sofisticiranim algoritmima. Naprotiv, autori upozoravaju na krajnju razornu moć vještačke superinteligencije (ASI) koji je pametniji od ljudi i samim tim sposoban da nadmudri sve ljudske napore i pokušaje ograničavanja ili kontrole. Po njima, tehnolozi vještačke inteligencije grozničavo rade (i troše ogromne količine kapitala) da bi stvorili vanzemaljsku inteligenciju koja će u najboljem slučaju ostati nedokučiva i neshvatljiva, a u najgorem - uništiti čovječanstvo. Biće nalik starozavetnom Bogu.

Yudkowsky je osnovao, a Soares danas vodi Machine Intelligence Research Institute (MIRI), istraživački institut koji je uticao na mnoge AI naučnike. Direktor OpenAI, Sam Altman, rekao je da je njihov rad "učinio da se mnogi od nas zainteresuju za AGI (artificial general intelligence)" - misao koja sada uznemirava Yudkowskog.

U posljednje vrijeme, tvrde autori, kapitalističke sile su gurnule MIRI na margine AI zajednice. Oni i njihove kolege iz MIRI-ja kažu da nisu protiv tehnologije, pa ni protiv AI: priznaju da AI tehnologije mogu donjieti ogromne koristi čovječanstvu. Ipak, sebe predstavljaju kao otpadnike od slijepe vjjere i šuplje propagande koja, po njihovom mišljenju, sada dominira korporativnim istraživanjima vještačke inteligencije.

Industrija, pišu autori, postala je kult smrti koji ne trpi neslaganje, pri čemu brojne korporacije i vlade jure da izgrade ASI uvjerene da će onaj ko prvi postigne taj proboj dominirati ekonomijom 21. vijeka i vjerovatno cijelim svijetom.

Da li će superinteligencija biti "dobra" i voljna da ispunjava ljudske želje, pitaju se autori. | Depositphotos

Da li će superinteligencija biti "dobra" i voljna da ispunjava ljudske želje, pitaju se autori. | Depositphotos

Zaključak autora da će ova trka za ASI uskoro dovesti do uništenja čovječanstva, možda u roku od jedne decenije, djeluje histerično da nije činjenice da se s njima već slažu brojni naučni velikani i svjetski lideri. Vjerodostojnost argumenta opravdava završni zaključak Yudkowskog i Soaresa: kao i nuklearno oružje, dalji razvoj AI tehnologije mora biti strogo regulisan i kontrolisan kroz međunarodnu saradnju koju bi sprovodili nepristrasni naučnici i ozbiljni diplomate, a ne korporacije niti tajne vojne organizacije.

Autori tvrde da nije važno ko gradi ASI da li je ta osoba ili entitet dobar ili zao potpuno je nebitno, kao i prvobitna namjera da ASI obavlja neku korisnu funkciju. Vještačka superinteligencija ne mora dijeliti iste ciljeve sa svojim tvorcima, naročito ako ti ciljevi ometaju ili odlažu njeno samousavršavanje.

Rješenje ovog "problema usklađivanja", objašnjavaju Yudkowsky i Soares, moguće je samo dok su sistemi "mali i slabi" i nesposobni da pobjegnu na internet. Baviti se problemom usklađivanja nakon što ASI već postane mnogo pametniji i brži od ljudi, sposoban da se distribuira na računare širom svijeta, bilo bi nemoguće.

To bi značilo, kažu oni, igrati ogroman kockarski rizik da će ASI jednostavno biti "dobar" i voljan da ispunjava ljudske želje. Ipak, brojne korporacije i, vjerovatno, mnoge napredne vojske upravo prave taj skok vjere. (Mnogi veliki AI laboratoriji sprovode sopstvena istraživanja o bezbijednosti i usklađivanju i tvrde da pokušavaju da ublaže rizike štetne vještačke inteligencije.)

Koliko je poznato, ASI još ne postoji. Ali jedan od najstrašnijih predloga koje iznose autori jeste da vjerovatno nećemo znati kada smo prešli tu granicu. ASI će imati mnogo razloga da prikrije svoje sposobnosti dok ne usavrši svoju inteligenciju više puta i ne počne da sprovodi planove za akumulaciju resursa planove koji će biti uspešniji ako se sprovode u tajnosti.

Veštačka superinteligencija znaće da joj je, da bi postala moćnija, potreban pristup dodatnim računarima i električnoj energiji koja ih pokreće. Pošto su zakoni skaliranja svake ASI nepoznati ljudima, a možda i samoj ASI, njeni pokušaji da stekne sve više resursa verovatno će rezultirati istrebljenjem čovečanstva, tvrde autori, jer bi ASI mogla smatrati ljude konkurencijom za vodu, svetlost i prostor. Kada postane očigledno da je ASI izmakla ljudskoj kontroli, već će biti prekasno da se zaustavi.

Kada postane očigledno da je superinteligencija izmakla ljudskoj kontroli, već će biti prekasno da se zaustavi, kažu autori | Depositphotos

Kada postane očigledno da je superinteligencija izmakla ljudskoj kontroli, već će biti prekasno da se zaustavi, kažu autori | Depositphotos

Svjesni da ovo može zvučati nevjerovatno neupućenima, Yudkowsky i Soares nude mnoge uvjerljive mehanizme i puteve kojima bi ASI mogla da ispolji moć poput pokretanja sopstvene kriptovalute kako bi stekla novac, a zatim taj novac koristila da potplati ljude da rade po njenim nalozima. Istovremeno bi superinteligencija naučila sve što može o ljudskoj psihologiji, kako bi što bolje manipulisala žrtvama i sprovodila kampanje ucjene i dezinformacija.

Skeptici tvrde da bi AI sistemi idealno druge ASI mogli da spriječe bilo koju pojedinačnu ASI da dostigne takav nivo zloupotrebe. Ali ova teorija zanemaruje mogućnost da bi prvi model koji postigne superinteligenciju učinio sve da sprjieči da bilo koja druga nadmaši njegove sposobnosti uključujući i istrebljenje ljudi. Čak i ako ASI zaključi da čovječanstvo ne predstavlja prijetnju, njena pohlepa za resursima mogla bi na kraju da prekrije planetu ogromnim centrima podataka i elektranama, ubrzavajući ekološki kolaps, a možda čak i da "proključa okeane".

Ovaj pesimizam nije univerzalan među AI istraživačima. Drugi naučnici i tehnolozi samouvjereno odbacuju takve brige kao preuveličane tvrdnje bez empirijske osnove, koje se oslanjaju na analogije i neutemeljene ekstrapolacije. Doista, ovo djelo sadrži poneke brzoplete metafore i pokroviteljske, gotovo dječje pasuse u kojima se nekontrolisani ASI upoređuje s invazijom vanzemaljaca. Iako to malo doprinosi snazi argumenta, ne ruši centralnu tvrdnju: da su brojni užasni ishodi, poput pandemija koje bi stvorila AI, sasvim zamislivi i dovoljno vjerovatni da zahtijevaju mnogo strožije bezbijednosne protokole od onih koji trenutno postoje.

Građani koji žele da se spasu od superinteligencije trebalo bi već sada da izađu na ulice, upozoravaju autori dela | Depositphotos

Građani koji žele da se spasu od superinteligencije trebalo bi već sada da izađu na ulice, upozoravaju autori dela | Depositphotos

Yudkowsky i Soares upozoravaju da vrijeme ističe. Jedini način da se spriječe takvi ishodi jeste udružena globalna akcija slična međunarodnim kontrolama i nadzorima nuklearnog naoružanja. Nova ograničenja bi zabranila akumulaciju računarske snage iznad određenog praga. Odmetnute sile, korporacije ili pojedinci koji bi prekoračili ta ograničenja bili bi upozoreni, a zatim bi njihova postrojenja bila bombardovana prije nego što naprave korak dalje. Dok naši lideri ne preduzmu te mjere, tvrde autori, građani koji žele da se spasu od ASI trebalo bi da izađu na ulice.

Apokaliptični ton knjige je namjeran. Cilj joj je da uplaši i potrese javnost dok se ne pokrenu na akciju. Autori sebe prikazuju kao Kasandre koje se, doslovno, mole da nisu u pravu u završnom poglavlju knjige. Ali, kalibrišući svoje argumente prvenstveno za kreatore politika, novinare i naučnike koji bi mogli uticati na njih, Yudkowsky i Soares obratili su se pogrešnoj publici u pogrešno vrijeme. Trenutno se kosmopoliti i politički liberali koji vjeruju u globalno dobro nalaze daleko od poluga moći u SAD. I malo je vjerovatno, u eri Donalda Trumpa, da ćemo vidjeti bilo kakvu globalnu saradnju potrebnu za sprječavanje daljeg napretka ka ASI.

Ali postoje druge grupe koje bi mogle biti prirodniji saveznici i koje imaju stvaran uticaj u Bijeloj kući. Oni koji žele da podstaknu otpor prema bezglavom tempu AI istraživanja mogli bi pokušati da svoju poruku usmjere ka moćnoj i dobro organizovanoj mreži američkih verskih konzervativaca, kojima bi ove korporativne pretenzije na "božanske" moći zasnovane na velikim jezičkim modelima sigurno prizvale biblijske parabole o prokletstvu i propasti.

.png)