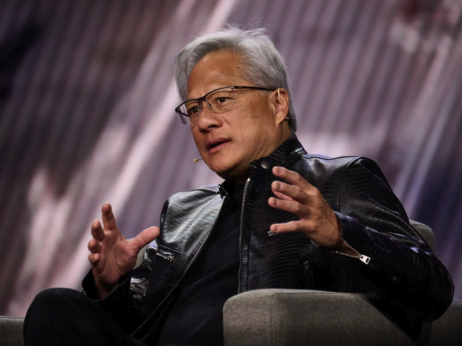

Dok Silicijska dolina početkom 2026. godine već juri za prvim isporukama Blackwell arhitekture, novih Nvidia čipova, a u industriji se sve otvorenije govori o sljedećoj generaciji pod imenom Rubin, Kina je dobila zeleno svjetlo za kupovinu tehnologije koju Zapad više ne smatra vrhunskom ponudom.

Dozvola za izvoz Nvidia H200 čipova u Kinu nije samo tržišni potez vrijedan više od 40 milijardi dolara, već hladno proračunata geopolitička odluka: omogućiti Pekingu pristup današnjoj infrastrukturi kako bi mu sutrašnja ostala nedostižna.

Kineske kompanije već su naručile između 1,5 miliona i dva miliona H200 čipova, iznos koji višestruko premašuje godišnju proizvodnju prethodne generacije H100. Formalno, to je velika stvar za Nvidiju. Suštinski, to je priznanje da H200 u 2026. godini više nije "dragulj", već nova industrijska norma: dovoljno moćna da pokrene ekonomiju umjetne inteligencije, ali ne dovoljno da ugrozi tehnološku prednost koju Zapad gradi s Blackwellom i budućim Rubinom.

Iza ove odluke krije se još dublja ironija. Kina ne kupuje H200 samo zato što ne može nabaviti novije čipove, već zato što ne može lako pobjeći iz Nvidijinog softverskog ekosistema. CUDA, Nvidijin programski okvir za GPU čipove, postao je de facto standard za razvoj umjetne inteligencije.

Velika većina postojećih AI sistema, alata i biblioteka napisana je posebno za CUDA okruženje, što prelazak na alternativni hardver čini tehnički rizičnim i ekonomski skupim. Čak i ako kineske kompanije razviju konkurentni hardver, ovisnost o softveru ostaje.

U tom kontekstu, dozvola za izvoz H200 u Kinu nije znak slabosti, već oblik kontroliranog usporavanja. Kina dobiva pristup čipovima koji su kompatibilni s CUDA ekosistemom, čime se dodatno veže za Nvidijin softver, dok joj najnovije arhitekture ostaju izvan svog dosega. To je ulaznica za utrku u kojoj je startna linija namjerno pomaknuta unazad.

Do jučer je H200 bio ekskluzivna infrastruktura rezervirana za najnaprednije laboratorije. Meta je trenirala Llama modele na desecima hiljada tih čipova odjednom, dok su Google, Amazon i Microsoft kupili sve što je Nvidia mogla isporučiti.

Automobilska industrija ih je koristila za razvoj autonomne vožnje, a farmaceutske kompanije za simuliranje molekula novih lijekova. Danas taj isti H200 postaje "dozvoljena" tehnologija za Kinu – ne zato što je beznačajan, već zato što Zapad već gradi sljedeći nivo.

Bloomberg

Bloomberg

Čitaj više

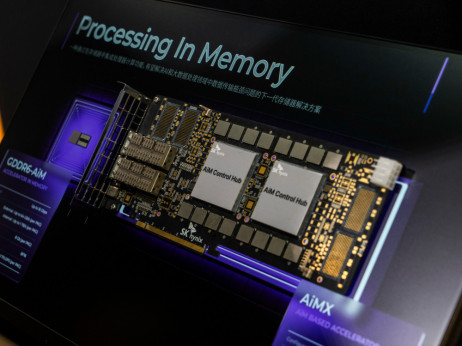

AI guta memoriju, a tržište i dalje potcjenjuje njene proizvođače

Iako se vještačka inteligencija ubrzano širi kroz gotovo sve industrije, njen daljnji rast sve više zavisi od fizičkih ograničenja u snabdijevanju ključnim komponentama. Samsung, Micron i SK Hynix danas stoje u samom centru, određujući tempom ponude koliko brzo se AI može razvijati.

21.01.2026

Nvidia je zaključila licencni sporazum sa startupom Groq

Najveća javno izlistana kompanija na svijetu sklopila je licencni dogovor sa AI startupom Groq.

25.12.2025

AI-balon: Je li investicija od 400 milijardi dolara samo skupa iluzija

Kompanije za umjetnu inteligenciju u ovoj godini imaju prihode od 60 milijardi dolara i ulaganja od 400 milijardi dolara.

15.12.2025

Nvidija može da izvozi H200 čipove u Kinu, ali uz dodatnu taksu

Predsjednik Donald Trump odobrio je Nvidiji izvoz H200 čipova za vještačku inteligenciju u Kinu, uz obaveznu taksu od 25 odsto.

09.12.2025

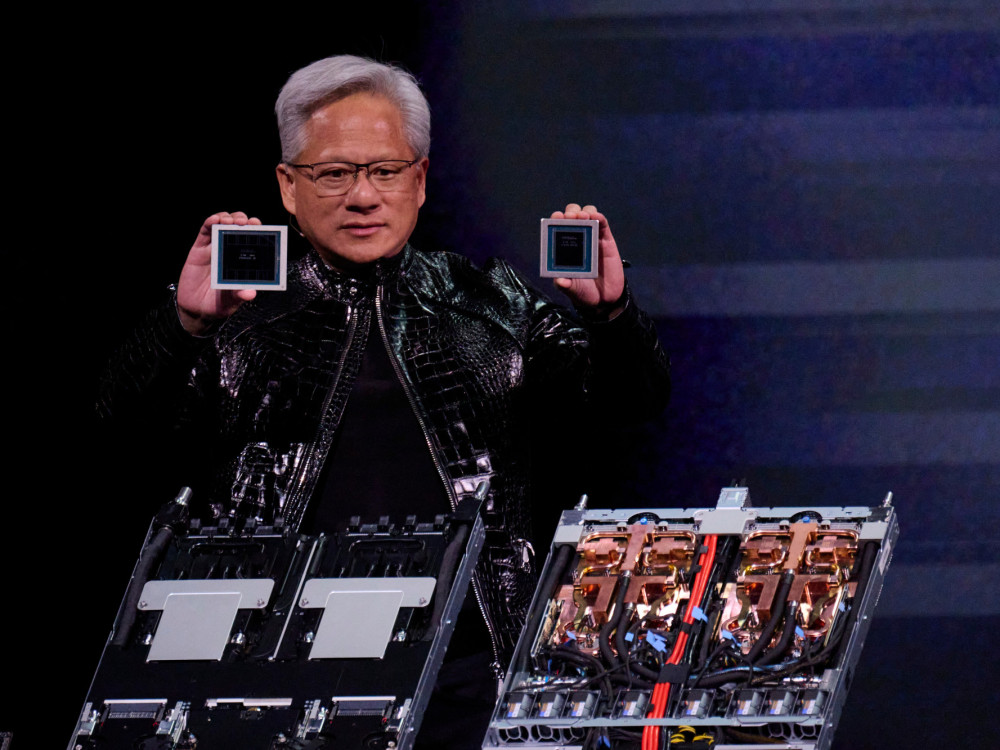

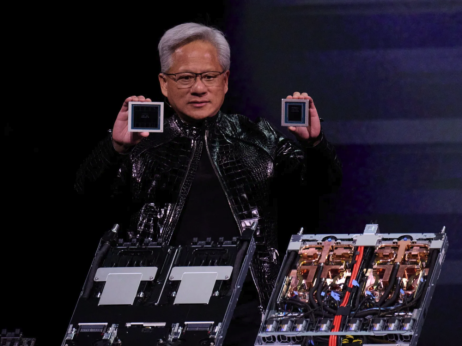

Šta je H200 i zašto nije običan GPU

H200 je grafički procesor dizajniran isključivo za umjetnu inteligenciju. Za razliku od GPU čipova u prijenosnim računarima, čija je osnovna uloga renderirati grafiku u videoigrama ili prikazivati videosadržaj, H200 ne "crta slike". On izvodi matematičke operacije, milijarde njih istovremeno.

Fizički, H200 je otprilike veličine knjige, dok je klasični GPU veličine poštanske marke. Razlika u memoriji je još drastičnija: dok tipični GPU za gaming ima oko 16 gigabajta memorije, H200 ima 141 gigabajt ultrabrze memorije. U praksi to znači da H200 može držati i obrađivati ogromne AI modele direktno u memoriji, bez stalnog prebacivanja podataka.

Kad je riječ o snazi, H200 je do sto puta snažniji od najmoćnijih gaming GPU čipova u zadacima vezanim za umjetnu inteligenciju. Upravo ta razlika čini granicu između "AI aplikacije" i "AI infrastrukture".

Zašto svijet ne može proizvesti dovoljno H200 čipova

Nvidia sama ne proizvodi H200. Ovaj čip prolazi kroz desetke tvornica raspoređenih na tri kontinenta. Tajvanski TSMC proizvodi sam procesor i integrira ga s memorijom. Južnokorejske kompanije SK Hynix i Micron proizvode HBM memoriju, specijaliziranu ultrabrzu memoriju bez koje savremeni AI čipovi ne mogu funkcionirati. Japanske kompanije isporučuju ključne podloge.

Usko grlo cijelog sistema nalazi se u TSMC-jevoj CoWoS tehnologiji pakiranja, procesu koji spaja procesor i memoriju u jednu cjelinu. Nvidia je rezervirala više od polovice globalnih CoWoS kapaciteta do 2027. godine, što znači da AMD, Intel, ali i cloud giganti s vlastitim čipovima dijele ostatak.

Razlog zašto je CoWoS ključan leži u brzini. U klasičnim GPU sistemima, procesor i memorija su povezani putem matične ploče, žicama koje fizički ograničavaju protok podataka. U H200, memorija i procesor su na istoj podlozi. Razlika je kao između slanja pisma poštom i predaje informacija iz ruke u ruku. U svijetu umjetne inteligencije, ta se razlika mjeri u desetke puta bržem pristupu podacima, što direktno utječe na sposobnost treniranja velikih modela.

U 2026. i 2027. godini tržište više ne muče nestašice kao 2024. godine, ali lanac opskrbe ostaje krhak. Svaki poremećaj, od geopolitičkih napetosti do prirodnih katastrofa u Aziji, može zaustaviti isporuke i usporiti cijelu industriju.

Što se tiče drugih konkurenata na tržištu, AMD isprobava MI300X čip koji ima 192 gigabajta memorije, dok Google, Amazon i Microsoft izrađuju vlastite čipove. Googleov TPU je dobar za vlastite modele, ali nije univerzalan, a nije ni Amazonov Trainium. Situacija je slična Intelovoj dominaciji na tržištu PC procesora u 1990-im; svi znaju da monopol nije zdrav, ali niko nema bolju alternativu.

Adria regija: gdje su naši čipovi?

Dok globalni divovi ulažu desetke milijardi dolara u vlastitu AI infrastrukturu, Adria regija se oslanja na starije generacije čipova i cloud usluge.

Argument je uvijek isti: cijena. Jedan server s osam H200 čipova košta koliko i trosoban stan u centru Zagreba. Za većinu regionalnih kompanija to je nedostižna investicija, pa se računalna snaga iznajmljuje od globalnih pružatelja cloud usluga.

Pitanje je, međutim, je li to dugoročno održiva strategija. Ako se regija trajno odrekne vlastite infrastrukture i zadovolji se ulogom korisnika tuđih modela, riskira da ostane tržište, a ne proizvođač vrijednosti. A100 čipovi su dovoljni za chatbotove i analitiku, ali nisu osnova za treniranje modela koji oblikuju novu ekonomiju.

Bez vlastite infrastrukture, naša regija riskira da postane digitalna kolonija koja plaća najamninu za tuđu infrastrukturu.

.png)